Redaktörens anmärkning: Vi har uppdaterat vårt ursprungliga inlägg om skillnaderna mellan GPU och processorer, författad av Kevin Krewell, och publicerad i December 2009.

CPU (central processing unit) har kallats hjärnan hos en dator. GPU sin själ. Under det senaste decenniet har GPU: er dock brutit ut ur de boxiga gränserna för datorn.

GPU: er har tänt en världsomspännande AI-BOM. De har blivit en viktig del av modern supercomputing., De har vävts in i nya hyperskala datacenter. Fortfarande uppskattad av spelare, de har blivit acceleratorer påskynda alla typer av uppgifter från kryptering till nätverk till AI.

och de fortsätter att driva framsteg inom spel och Pro-grafik inuti arbetsstationer, stationära datorer och en ny generation bärbara datorer.

Vad Är en GPU?

medan GPU: er (grafikbehandlingsenhet) nu handlar om mycket mer än de datorer där de först uppträdde, förblir de förankrade i en mycket äldre idé som heter parallel computing. Och det är det som gör GPU så kraftfull.

processorer, för att vara säker, förblir väsentliga. Snabb och mångsidig, processorer ras genom en rad uppgifter som kräver massor av interaktivitet. Ringa upp information från en hårddisk som svar på användarens tangenttryckningar, till exempel.

däremot bryter GPU-enheter komplexa problem i tusentals eller miljontals separata uppgifter och arbetar ut dem på en gång.,

det gör dem idealiska för grafik, där texturer, belysning och rendering av former måste göras på en gång för att hålla bilder som flyger över skärmen.,v id=”bdcf9e66d4″>

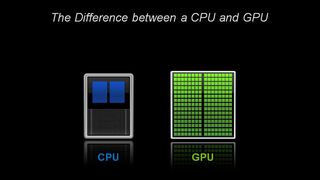

arkitektoniskt består CPU: n av bara några kärnor med massor av cacheminne som kan hantera några programvarugängor åt gången., Däremot består en GPU av hundratals kärnor som kan hantera tusentals trådar samtidigt.

GPU: er levererar den en gång esoteriska tekniken för parallell databehandling. Det är en teknik med en lysande stamtavla som innehåller namn som supercomputing genius Seymor Cray. Men snarare än att ta formen av hulking superdatorer, GPU sätta denna idé att arbeta i stationära och spelkonsoler på mer än en miljard spelare.

för GPU: er, datorgrafik först av många appar

den applikationen — datorgrafik — var bara den första av flera mördarappar., Och det drivs den enorma r&D-motorn bakom GPU framåt. Allt detta gör det möjligt för GPU att tävla före mer specialiserade, fasta funktionschips som betjänar nischmarknader.

en annan faktor som gör all den kraften tillgänglig: CUDA. Först släpptes 2007, parallel computing platform låter kodare dra nytta av datorkraft GPU för allmän bearbetning genom att infoga några enkla kommandon i deras kod.

det låter GPU proliferera i överraskande nya fält., Och med stöd för ett snabbt växande antal standarder-som Kubernetes och Dockers — kan applikationer testas på en billig stationär GPU och skalas ut till snabbare, mer sofistikerade server — GPU samt varje större molntjänstleverantör.

processorer och slutet av Moores lag

med Moores lag avveckling, GPU, uppfanns av NVIDIA i 1999, kom precis i tid.

Moores lag innebär att antalet transistorer som kan proppas i en integrerad krets kommer att fördubblas ungefär vartannat år. I årtionden har det drivit en snabb ökning av datorkraften., Denna lag har dock gått upp mot hårda fysiska gränser.

GPU — enheter erbjuder ett sätt att fortsätta accelerera applikationer — till exempel grafik, supercomputing och AI-genom att dividera uppgifter bland många processorer. Sådana acceleratorer är kritiska för halvledarnas framtid, enligt John Hennessey och David Patterson, vinnare av 2017 am Turing Award och författare till dataarkitektur: ett kvantitativt tillvägagångssätt den seminala läroboken om mikroprocessorer.,

GPU: nyckel till AI, datorseende, Supercomputing och mer

under det senaste decenniet som är bevisat nyckeln till ett växande utbud av applikationer.

GPU: er utför mycket mer arbete för varje energienhet än processorer. Det gör dem nyckeln till superdatorer som annars skulle driva förbi gränserna för dagens elektriska nät.

i AI, GPU har blivit nyckeln till en teknik som kallas ”deep learning.”Deep learning häller stora mängder data genom neurala nätverk, tränar dem för att utföra uppgifter för komplicerade för någon mänsklig kodare att beskriva.,

AI och Gaming: GPU-drivna Deep Learning kommer Full Circle

att djup inlärningskapacitet accelereras tack vare införandet av dedikerade Tensor kärnor i NVIDIA GPU. Tensorkärnor accelererar stora matrisoperationer, i hjärtat av AI, och utför blandade precisionsmatris multiplicera och ackumulera beräkningar i en enda operation. Det snabbar inte bara traditionella AI-uppgifter av alla slag, Det är nu utnyttjas för att påskynda spel.,

inom bilindustrin erbjuder GPU många fördelar. De ger oöverträffad bildigenkänningskapacitet, som du förväntar dig. Men de är också nyckeln till att skapa självkörande fordon som kan lära av — och anpassa sig till-ett stort antal olika verkliga scenarier.,

i robotteknik är GPU-enheter nyckeln till att göra det möjligt för maskiner att uppfatta sin miljö, som du förväntar dig. Deras AI-kapacitet har dock blivit nyckeln till maskiner som kan lära sig komplexa uppgifter, till exempel att navigera autonomt.

inom hälso-och biovetenskap erbjuder GPU många fördelar. De är idealiska för bilduppgifter, förstås. Men GPU-baserade djupa lärande snabbar analysen av dessa bilder. De kan krossa medicinska data och hjälpa till att göra dessa data, genom djupt lärande, till nya möjligheter.

kort sagt har GPU: er blivit väsentliga. De började med att accelerera spel och grafik., Nu accelererar de fler och fler områden där computing hästkrafter kommer att göra skillnad.

- AI äter programvara

- AI Driver uppkomsten av accelererad databehandling i datacenter

- Vad är skillnaden mellan hårdvara och mjukvara accelererad Ray Tracing?

- Vad Är Max-Q?

- Vad är en virtuell GPU?

- Vad är skillnaden mellan Ray Tracing och Rasterization?,

- Vad är skillnaden mellan artificiell intelligens, maskininlärning och djupt lärande?

- Vad Är NVLink?

- Vad är CUDA?