Editor nota: nós atualizamos nosso post original sobre as diferenças entre GPUs e CPUs, de autoria de Kevin Krewell, e publicado em dezembro de 2009.

A CPU (unidade central de processamento) tem sido chamada de cérebro de um PC. A GPU a sua alma. Ao longo da última década, no entanto, as GPUs têm quebrado fora dos limites de caixa do PC.

GPUs acenderam um boom AI mundial. Tornaram-se uma parte fundamental da supercomputação moderna., Eles foram feitos em novos centros de dados de hiper-escala. Ainda valorizados pelos jogadores, eles tornaram-se aceleradores acelerando todos os tipos de tarefas, desde a criptografia até a rede de inteligência artificial.

E eles continuam a impulsionar avanços em jogos e gráficos pro dentro de estações de trabalho, pcs de desktop e uma nova geração de laptops.o que é uma GPU?

Enquanto a Gpu (unidade de processamento de gráficos) são agora muito mais que os PCs em que eles apareceram pela primeira vez, eles permanecem ancoradas em uma muito mais antiga idéia chamado de computação paralela. E é isso que torna as GPUs tão poderosas.CPUs, para ter a certeza, continuam a ser essenciais. Rápida e versátil, corrida CPUs através de uma série de tarefas que exigem muita interatividade. Chamando informações de um disco rígido em resposta às teclas do usuário, por exemplo.

Em contraste, as GPUs dividem problemas complexos em milhares ou milhões de tarefas separadas e resolvem-nos de uma vez.,

que os torna ideais para gráficos, onde texturas, iluminação e a renderização de formas têm de ser feitas imediatamente para manter as imagens voando através da tela.,v id=”bdcf9e66d4″>

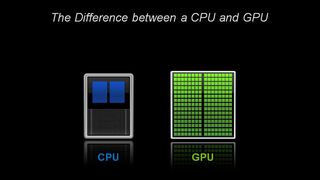

de Arquitetura, a CPU é composta de apenas alguns núcleos com muita memória cache que pode lidar com alguns software de linhas de cada vez., Em contraste, uma GPU é composta de centenas de núcleos que podem lidar com milhares de threads simultaneamente.

GPUs deliver the once-esoteric technology of parallel computing. É uma tecnologia com um ilustre pedigree que inclui nomes como o génio supercomputante Seymor Cray. Mas ao invés de tomar a forma de supercomputadores hulking, a GPUs colocou esta idéia para trabalhar nos desktops e consoles de jogos de mais de um bilhão de jogadores.

para GPUs, os gráficos de computador primeiro de muitos aplicativos

que a aplicação-Gráficos de computador-foi apenas o primeiro de vários aplicativos killer., E é impulsionado o enorme R&d motor atrás de GPUs para frente. Tudo isso permite que a GPUs corra à frente de chips de função fixa mais especializados que servem nichos de mercado.

outro fator que torna toda essa potência acessível: CUDA. Lançado pela primeira vez em 2007, a plataforma de computação paralela permite aos programadores tirar partido do poder de computação das GPUs para processamento de propósito geral, inserindo alguns comandos simples em seu código.isso deixa as GPUs proliferarem em novos campos surpreendentes., E com suporte para um rápido crescimento de padrões — como Kubernetes e Dockers-aplicativos podem ser testados em uma GPU desktop de baixo custo e dimensionados para GPUs de servidor mais rápido e sofisticado, bem como todos os principais provedores de serviços na nuvem.

CPUs and the End of Moore’s Law

With Moore’s law winding down, GPUs, invented by NVIDIA in 1999, came just in time.a lei de Moore postula que o número de transístores que podem ser amontoados em um circuito integrado dobrará a cada dois anos. Durante décadas, isso levou a um rápido aumento do poder da computação., Essa Lei, no entanto, tem corrido contra os duros limites físicos.

GPUs oferece uma maneira de continuar acelerando aplicações – tais como gráficos, supercomputação e AI — dividindo tarefas entre muitos processadores. Tais aceleradores são críticos para o futuro dos semicondutores, de acordo com John Hennessey e David Patterson, vencedores do Prêmio Turing da manhã de 2017 e autores da arquitetura de computador: uma abordagem quantitativa do livro didático seminal sobre microprocessadores.,

GPUs: Key to AI, Computer Vision, Supercomputing and More

Over the past decade that’s proved key to a growing range of applications.

GPUs executar muito mais trabalho para cada unidade de energia do que CPUs. Isso faz deles a chave para supercomputadores que, de outra forma, ultrapassariam os limites das redes eléctricas de hoje.

em AI, as GPUs tornaram-se a chave para uma tecnologia chamada “aprendizagem profunda”.”A aprendizagem profunda envia grandes quantidades de dados através de redes neurais, treinando-os para executar tarefas muito complicadas para qualquer programador humano descrever.,

AI and Gaming: GPU-Powered Deep Learning Comes Full Circle

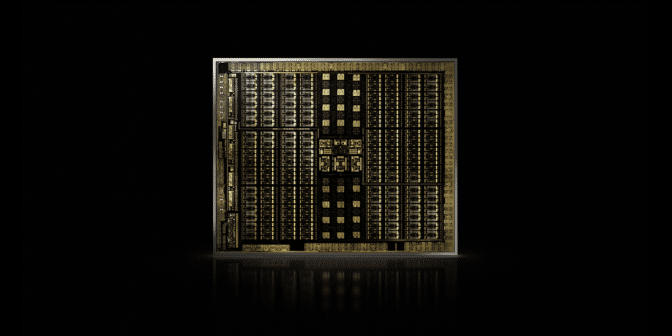

That deep learning capability is accelerated agradecimentos to the inclusion of dedicated Tensor Cores in Nvidia GPUs. Núcleos tensores aceleram grandes operações de matriz, no coração da IA, e realizam cálculos de multiplicação e acumulação de matriz de precisão mista em uma única operação. Que não só acelera as tradicionais tarefas de IA de todos os tipos, como está agora a ser aproveitado para acelerar os jogos.,

Na indústria automotiva, as GPUs oferecem muitos benefícios. Eles fornecem capacidades de reconhecimento de imagens incomparáveis, como seria de esperar. Mas eles também são a chave para a criação de veículos auto-dirigindo capaz de aprender com — e se adaptar a — um grande número de diferentes cenários do mundo real.,

em robótica, as GPUs são a chave para permitir que as máquinas percebam o seu ambiente, como seria de esperar. Suas capacidades de IA, no entanto, tornaram-se a chave para máquinas que podem aprender tarefas complexas, como navegar autonomamente.em cuidados de saúde e Ciências da vida, As GPUs oferecem muitos benefícios. São ideais para tarefas de imagem, claro. Mas a aprendizagem profunda baseada na GPU acelera a análise dessas imagens. Eles podem criar dados médicos e ajudar a transformar esses dados, através da aprendizagem profunda, em novas capacidades.em resumo, as GPUs tornaram-se essenciais. Eles começaram por acelerar jogos e gráficos., Agora eles estão acelerando mais e mais áreas onde a computação de cavalos fará a diferença.

- AI Is Eating Software AI Drives the Rise of Accelerated Computing in Data Centers What’s the Difference Between Hardware and Software Accelerated Ray Tracing? O Que É Max-Q? O que é uma GPU Virtual? Qual é a diferença entre o traçado de raios e a rasterização?, Qual é a diferença entre Inteligência Artificial, aprendizagem de máquinas e aprendizagem profunda? O que é NVLink? O que é CUDA?