Nota del redattore: Abbiamo aggiornato il nostro post originale sulle differenze tra GPU e CPU, scritto da Kevin Krewell e pubblicato nel dicembre 2009.

La CPU (central processing unit) è stato chiamato il cervello di un PC. La GPU la sua anima. Negli ultimi dieci anni, tuttavia, le GPU sono uscite dai confini squadrati del PC.

Le GPU hanno acceso un boom AI in tutto il mondo. Sono diventati una parte fondamentale del supercalcolo moderno., Sono stati intrecciati in nuovi data center hyperscale tentacolare. Ancora apprezzati dai giocatori, sono diventati acceleratori che accelerano tutti i tipi di attività, dalla crittografia alla rete all’IA.

E continuano a guidare i progressi nel gioco e nella grafica pro all’interno di workstation, PC desktop e una nuova generazione di laptop.

Che cos’è una GPU?

Mentre le GPU (unità di elaborazione grafica) sono ora molto più dei PC in cui sono apparse per la prima volta, rimangono ancorate a un’idea molto più vecchia chiamata calcolo parallelo. Ed è questo che rende le GPU così potenti.

Le CPU, per essere sicuri, rimangono essenziali. Veloci e versatili, le CPU corrono attraverso una serie di compiti che richiedono molta interattività. Richiamare le informazioni da un disco rigido in risposta alle sequenze di tasti dell’utente, per esempio.

Al contrario, le GPU rompono problemi complessi in migliaia o milioni di attività separate e li risolvono contemporaneamente.,

Che li rende ideali per la grafica, dove texture, illuminazione e il rendering delle forme devono essere fatte in una sola volta per mantenere le immagini che volano attraverso lo schermo.,v id=”bdcf9e66d4″>

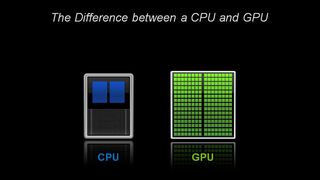

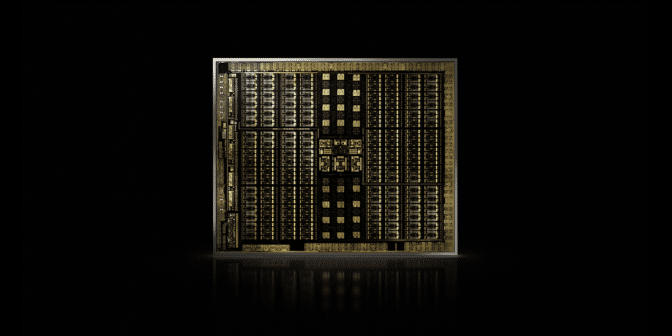

dal punto di vista Architettonico la CPU è composta da pochi nuclei con un sacco di memoria cache in grado di gestire un paio di software thread alla volta., Al contrario, una GPU è composta da centinaia di core in grado di gestire migliaia di thread contemporaneamente.

Le GPU offrono la tecnologia un tempo esoterica del calcolo parallelo. È una tecnologia con un pedigree illustre che include nomi come il genio del supercalcolo Seymor Cray. Ma piuttosto che prendere la forma di supercomputer massiccia, GPU messo questa idea di lavorare nei desktop e console di gioco di più di un miliardo di giocatori.

Per le GPU, Computer Grafica Prima di molte applicazioni

Tale applicazione — computer grafica — era solo la prima di diverse applicazioni killer., E ha guidato l’enorme motore R&D dietro le GPU in avanti. Tutto ciò consente alle GPU di competere con chip più specializzati e a funzione fissa che servono mercati di nicchia.

Un altro fattore che rende accessibile tutta quella potenza: CUDA. Rilasciato per la prima volta nel 2007, la piattaforma di calcolo parallelo consente ai programmatori di sfruttare la potenza di calcolo delle GPU per l’elaborazione generica inserendo alcuni semplici comandi nel loro codice.

Questo consente alle GPU di proliferare in nuovi campi sorprendenti., E con il supporto di un numero crescente di standard, come Kubernetes e Dockers, le applicazioni possono essere testate su una GPU desktop a basso costo e scalate su GPU server più veloci e sofisticate e su tutti i principali provider di servizi cloud.

CPU e la fine della legge di Moore

Con la legge di Moore che si sta esaurendo, le GPU, inventate da NVIDIA nel 1999, sono arrivate appena in tempo.

La legge di Moore afferma che il numero di transistor che possono essere stipati in un circuito integrato raddoppierà circa ogni due anni. Per decenni, questo ha determinato un rapido aumento della potenza di calcolo., Tale legge, tuttavia, ha incontrato limiti fisici duri.

GPU offre un modo per continuare ad accelerare le applicazioni — come la grafica, supercalcolo e AI — dividendo le attività tra molti processori. Tali acceleratori sono fondamentali per il futuro dei semiconduttori, secondo John Hennessey e David Patterson, vincitori del 2017 A. M. Turing Award e autori di Computer Architecture: A Quantitative Approach the seminal textbook on microprocessors.,

GPU: chiave per AI, Computer Vision, supercalcolo e altro ancora

Negli ultimi dieci anni si è dimostrato fondamentale per una gamma crescente di applicazioni.

Le GPU eseguono molto più lavoro per ogni unità di energia rispetto alle CPU. Questo li rende la chiave per supercomputer che altrimenti spingerebbero oltre i limiti delle reti elettriche di oggi.

Nell’IA, le GPU sono diventate la chiave per una tecnologia chiamata ” deep learning.”L’apprendimento profondo riversa grandi quantità di dati attraverso le reti neurali, addestrandoli a svolgere compiti troppo complicati da descrivere per qualsiasi programmatore umano.,

AI e gaming: il Deep Learning alimentato da GPU completa il cerchio

Che la capacità di deep learning viene accelerata grazie all’inclusione di Tensor Core dedicati nelle GPU NVIDIA. I Tensor Core accelerano le operazioni su matrici di grandi dimensioni, al centro dell’IA, ed eseguono calcoli di moltiplicazione e accumulo di matrici a precisione mista in un’unica operazione. Che non solo accelera le attività AI tradizionali di tutti i tipi, è ora sfruttato per accelerare il gioco.,

Nel settore automobilistico, le GPU offrono molti vantaggi. Essi forniscono capacità di riconoscimento delle immagini senza pari, come ci si aspetterebbe. Ma sono anche la chiave per creare veicoli a guida autonoma in grado di imparare da — e adattarsi a — un vasto numero di diversi scenari del mondo reale.,

Nella robotica, le GPU sono fondamentali per consentire alle macchine di percepire il loro ambiente, come ci si aspetterebbe. Le loro capacità di intelligenza artificiale, tuttavia, sono diventati la chiave per le macchine che possono imparare compiti complessi, come la navigazione autonomamente.

Nel settore sanitario e delle scienze della vita, le GPU offrono molti vantaggi. Sono ideali per le attività di imaging, ovviamente. Ma l’apprendimento profondo basato su GPU accelera l’analisi di quelle immagini. Possono crunch dati medici e contribuire a trasformare quei dati, attraverso l’apprendimento profondo, in nuove funzionalità.

In breve, le GPU sono diventate essenziali. Hanno iniziato accelerando il gioco e la grafica., Ora stanno accelerando sempre più aree in cui la potenza di calcolo farà la differenza.

- AI sta mangiando software

- AI guida l’ascesa del calcolo accelerato nei Data Center

- Qual è la differenza tra il ray tracing accelerato da hardware e software?

- Che cos’è Max-Q?

- Che cos’è una GPU virtuale?

- Qual è la differenza tra Ray Tracing e rasterizzazione?,

- Qual è la differenza tra intelligenza artificiale, apprendimento automatico e apprendimento profondo?

- Che cos’è NVLink?

- Che cos’è CUDA?