Cosa sono i Bot

Un bot Internet è un’applicazione software che esegue attività automatizzate su Internet. Le attività eseguite dai bot sono in genere semplici e eseguite a un tasso molto più elevato rispetto all’attività Internet umana.

Alcuni bot sono legittimi, ad esempio Googlebot è un’applicazione utilizzata da Google per eseguire la scansione di Internet e indicizzarla per la ricerca. Altri bot sono dannosi, ad esempio i bot utilizzati per scansionare automaticamente i siti Web alla ricerca di vulnerabilità software ed eseguire semplici schemi di attacco.,

Che cos’è una Botnet

Ci sono molti tipi di malware che infettano i dispositivi degli utenti finali, con l’obiettivo di arruolarli in una botnet. Qualsiasi dispositivo che viene infettato inizia a comunicare con un centro di comando e controllo (C&C) e può eseguire attività automatizzate sotto il controllo centrale dell’attaccante.

Molti attori delle minacce sono attivamente impegnati nella costruzione di enormi botnet, con le più grandi che coprono milioni di computer., Spesso, la botnet può crescere se stessa, ad esempio utilizzando dispositivi infetti per inviare e-mail di spam, che possono infettare più macchine.

I proprietari di botnet li utilizzano per attività dannose su larga scala, attacchi DDoS (Distributed Denial of Service). Le botnet possono essere utilizzate anche per qualsiasi altra attività bot dannosa, come i bot spam o i social bot (descritti di seguito), anche se su scala molto più ampia.

Tipi di bot

Esistono molti tipi di bot attivi su Internet, sia legittimi che dannosi. Di seguito sono riportati diversi esempi comuni.,

Spider Bot

Spider bot, noti anche come web spider o crawler, navigare sul web seguendo i collegamenti ipertestuali, con l’obiettivo di recuperare e indicizzare il contenuto web. Gli spider scaricano HTML e altre risorse, come CSS, JavaScript e immagini, e li usano per elaborare il contenuto del sito.

Se si dispone di un gran numero di pagine web, è possibile inserire un robot.file txt nella radice del server Web e fornire istruzioni ai bot, specificando quali parti del sito possono eseguire la scansione e con quale frequenza.,

Scraper Bot

Gli scraper sono bot che leggono i dati dei siti web con l’obiettivo di salvarli offline e consentirne il riutilizzo. Ciò può assumere la forma di raschiare l’intero contenuto delle pagine web o raschiare il contenuto web per ottenere punti dati specifici, come nomi e prezzi dei prodotti sui siti di e-commerce.

Il web scraping è un’area grigia-in alcuni casi, lo scraping è legittimo e può essere consentito dai proprietari di siti web. In altri casi, gli operatori bot potrebbero violare i termini di utilizzo del sito Web o, peggio, sfruttare lo scraping per rubare contenuti sensibili o protetti da copyright.,

Spam Bot

Uno spambot è un’applicazione Internet progettata per raccogliere indirizzi e-mail per le mailing list di spam. Un bot spam può raccogliere e-mail da siti web, siti web di social media, aziende e organizzazioni, sfruttando il formato distintivo degli indirizzi e-mail.

Dopo che gli aggressori hanno accumulato un ampio elenco di indirizzi e—mail, possono usarli non solo per inviare e-mail di spam, ma anche per altri scopi nefasti:

- Cracking delle credenziali-associazione di e-mail con password comuni per ottenere l’accesso non autorizzato agli account.,

- Modulo spam-inserimento automatico di spam, come annunci o link malware, in moduli su siti Web popolari, in genere moduli di commento o feedback.

Oltre al danno diretto causato agli utenti finali e alle organizzazioni colpite dalle campagne di spam, i bot spam possono anche soffocare la larghezza di banda del server e aumentare i costi per gli Internet Service Provider (ISP).

Social Media Bot

I bot sono gestiti su reti di social media e utilizzati per generare automaticamente messaggi, sostenere idee, agire come follower degli utenti e come account falsi per guadagnare follower., Si stima che il 9-15% degli account Twitter siano bot sociali.

I social bot possono essere usati per infiltrarsi in gruppi di persone e per propagare idee specifiche. Poiché non esiste una regolamentazione rigorosa che regola la loro attività, i robot sociali svolgono un ruolo importante nell’opinione pubblica online.

I bot sociali possono creare account falsi (anche se questo sta diventando sempre più difficile come i social network diventano più sofisticati), amplificare il messaggio dell’operatore bot, e generare seguaci falsi/Mi piace., È difficile identificare e mitigare i social bot, perché possono mostrare un comportamento molto simile a quello degli utenti reali.

Scaricare Bot

Scaricare bot sono programmi automatizzati che possono essere utilizzati per scaricare automaticamente software o applicazioni mobili. Possono essere utilizzati per influenzare le statistiche di download, ad esempio per ottenere più download su app store popolari e aiutare le nuove app a raggiungere la cima delle classifiche. Possono anche essere utilizzati per attaccare i siti di download, creando download falsi come parte di un attacco DoS (Application-Layer Denial of Service).,

Ticketing Bot

Ticketing Bot sono un modo automatico per acquistare i biglietti per eventi popolari, con l’obiettivo di rivendere quei biglietti per un profitto. Questa attività è illegale in molti paesi, e anche se non vietata dalla legge, è un fastidio per gli organizzatori di eventi, venditori di biglietti e consumatori.

I bot di ticketing tendono ad essere molto sofisticati, emulando gli stessi comportamenti degli acquirenti di biglietti umani. In molti domini di ticketing, la percentuale di biglietti acquistati da bot automatici varia tra il 40-95%.,

Come rilevare il traffico Bot in Web Analytics

Di seguito sono riportati alcuni parametri che è possibile utilizzare in un controllo manuale della vostra analisi web, per rilevare il traffico bot colpire un sito web:

- Tendenze del traffico—picchi anomali nel traffico potrebbero indicare bot colpire il sito. Ciò è particolarmente vero se il traffico si verifica durante le ore dispari.

- Frequenza di rimbalzo-alti o bassi anormali possono essere un segno di bot cattivi. Ad esempio, i bot che colpiscono una pagina specifica sul sito e quindi cambiano IP appariranno con un rimbalzo del 100%.,

- Fonti di traffico-durante un attacco dannoso, il canale principale che invia il traffico è il traffico “diretto” e il traffico sarà composto da nuovi utenti e sessioni.

- Prestazioni del server-un rallentamento delle prestazioni del server può essere un segno di bot.

- IP sospetti / geolocalizzazioni: un aumento dell’attività in un intervallo IP sconosciuto o in una regione in cui non svolgi attività.

Colpi sospetti da singoli IP—un gran numero di colpi da un singolo IP. Gli umani in genere richiedono alcune pagine e non altre, mentre i bot richiedono spesso tutte le pagine., - Fonti di lingua-vedere i risultati di altre lingue che i tuoi clienti non usano in genere.

Tutto quanto sopra sono solo indicatori approssimativi dell’attività del bot. Tieni presente che sofisticati bot dannosi possono generare una firma realistica e simile all’utente nelle tue analisi Web. Si consiglia di utilizzare una soluzione di gestione bot dedicata che fornisce piena visibilità del traffico bot.

Come fermare il traffico dei bot: Misure di mitigazione di base

Ci sono alcune semplici misure che puoi adottare per bloccare almeno alcuni bot e ridurre l’esposizione ai bot cattivi:

- Posiziona i robot.,txt nella radice del tuo sito web per definire quali bot sono autorizzati ad accedere al tuo sito web. Tenete a mente, questo è efficace solo per la gestione dei modelli di scansione di bot legittimi, e non protegge contro l’attività bot dannosi.

- Aggiungi su iscriviti, commenta o scarica i moduli. Molti editori e siti web premium posto per impedire il download o spam bot.

- Imposta un avviso JavaScript per notificare il traffico bot. Avere JavaScript contestuale sul posto può fungere da cicalino e avvisare l’utente ogni volta che vede un bot o un elemento simile entrare in un sito web.,

In che modo i bot eludono il rilevamento?

La tecnologia bot si è evoluta negli ultimi dieci anni. In origine, i bot erano uno script che colpiva un sito Web per recuperare dati o eseguire azioni. Questi script non accettano i cookie e non analizzano JavaScript, rendendoli molto facili da rilevare.

Nel corso del tempo i bot sono diventati più sofisticati, accettando i cookie e analizzando JavaScript, ma potrebbero comunque essere rilevati abbastanza facilmente perché utilizzavano elementi dinamici del sito Web meno degli utenti umani.,

La prossima evoluzione è stata l’uso di browser senza testa come PhantomJS—questi possono elaborare il contenuto del sito web nella sua interezza. Anche se questi browser sono più sofisticati di bot di base, browser senza testa ancora non possono eseguire tutte le azioni che gli utenti reali possono.

I tipi più avanzati di bot sono basati sul browser Chrome e sono quasi indistinguibili dagli utenti reali. Questi bot simulano anche l’attività umana, ad esempio facendo clic su elementi della pagina.

Tecniche avanzate di mitigazione dei bot

Come i bot si sono evoluti, così ha fatto le tecniche di mitigazione., Attualmente esistono tre approcci tecnici per rilevare e mitigare i bot errati:

- Approccio statico—gli strumenti di analisi statica possono identificare le richieste Web e le informazioni di intestazione correlate ai bot errati, determinando passivamente l’identità del bot e bloccandolo se necessario.

- Approccio basato sulla sfida: puoi dotare il tuo sito web della possibilità di verificare in modo proattivo se il traffico proviene da utenti umani o bot. I rilevatori bot basati su sfide possono verificare la capacità di ciascun visitatore di utilizzare i cookie, eseguire JavaScript e interagire con gli elementi., Una ridotta capacità di elaborare questi tipi di elementi è un segno di traffico bot.

- Approccio comportamentale-un meccanismo di mitigazione del bot comportamentale esamina la firma comportamentale di ogni visitatore per vedere se è ciò che afferma di essere. La mitigazione dei bot comportamentali stabilisce una linea di base del comportamento normale per gli agenti utente come Google Chrome e verifica se l’utente corrente si discosta da tale comportamento. Può anche confrontare le firme comportamentali con precedenti firme note di bot errati.,

Combinando i tre approcci, è possibile superare i bot evasivi di tutti i tipi e separarli con successo dal traffico umano. È possibile utilizzare questi approcci in modo indipendente o si può fare affidamento su servizi di mitigazione bot per eseguire tecniche per voi.

I servizi di mitigazione dei bot sono strumenti automatizzati che utilizzano i metodi di cui sopra per identificare i bot. Questi servizi possono essere utilizzati per monitorare il traffico API e rilevare se si tratta di traffico macchina legittimo o bot cattivi “mungitura” l’API.,

I servizi avanzati di mitigazione dei bot utilizzano la limitazione della velocità per ogni client o macchina richiedente, invece di un intero IP, consentendo di limitare la scansione da bot errati. Una volta identificato un bot, questi servizi possono propagare le informazioni attraverso la rete, per garantire che lo stesso bot non possa accedere nuovamente al sito o all’API.

Scopri come Imperva Bot Management può aiutarti con le minacce automatiche.,

Gestione bot Imperva

La soluzione di gestione bot di Imperva utilizza tutti e tre gli approcci sopra descritti—statici, basati sulle sfide e basati sul comportamento-per indagare su ogni visitatore sul tuo sito, umano o meno, e abbinarlo a un ID comportamentale. Può proteggere efficacemente contro i bot dannosi, garantendo nel contempo che i bot legittimi e gli utenti umani abbiano accesso ininterrotto al tuo sito.,

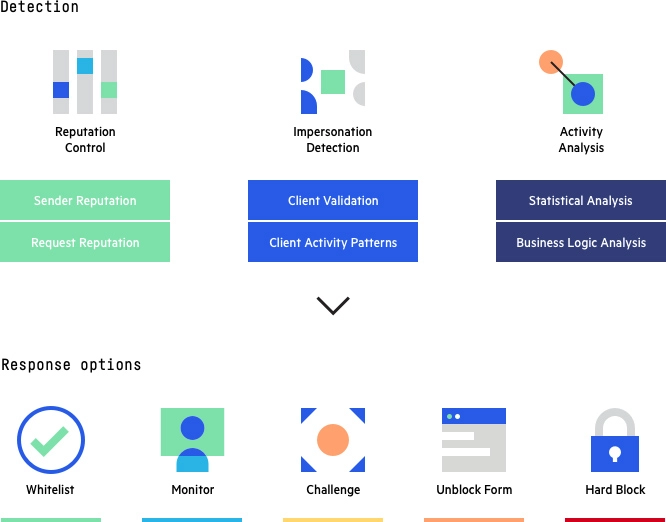

Gestione bot Imperva: metodi di rilevamento e opzioni di risposta

Oltre ad aiutare a mitigare l’attività bot difettosa, Imperva fornisce una protezione a più livelli per assicurarsi che siti web e applicazioni siano disponibili, facilmente accessibili e sicuri. La soluzione Imperva Application Security include:

- API security—protegge le API dai bot e dagli aggressori umani garantendo che solo il traffico desiderato possa accedere al tuo endpoint API, oltre a rilevare e bloccare gli exploit delle vulnerabilità.,

- DDoS Protection-mantenere uptime in tutte le situazioni. Impedisci a qualsiasi tipo di attacco DDoS, di qualsiasi dimensione, di impedire l’accesso al tuo sito web e all’infrastruttura di rete.

- CDN-migliora le prestazioni del sito web e riduci i costi di larghezza di banda con una CDN progettata per gli sviluppatori. Cache risorse statiche all’edge, accelerando le API e i siti Web dinamici.

- Web Application Firewall-consentire il traffico legittimo e prevenire il traffico cattivo. Proteggi le tue applicazioni all’avanguardia con un WAF cloud di classe enterprise.,

- RASP-mantenere le applicazioni al sicuro dall’interno contro gli attacchi noti e zero-day. Protezione veloce e precisa senza firma o modalità di apprendimento.

- Account Takeover Protection-utilizza un processo di rilevamento intent-based per identificare e difende contro i tentativi di prendere in consegna gli account degli utenti per scopi dannosi.