Anmerkung der Redaktion: Wir haben aktualisiert unsere original-Beitrag auf die Unterschiede zwischen GPUs und CPUs, verfasst von Kevin Krewell, und im Dezember 2009 veröffentlicht.

Die CPU (Central Processing Unit) wurde als Gehirn eines PCS bezeichnet. Die GPU seine Seele. In den letzten zehn Jahren sind GPUs jedoch aus den kastenförmigen Grenzen des PCS ausgebrochen.

GPUs haben einen weltweiten KI-Boom ausgelöst. Sie sind ein wichtiger Bestandteil des modernen Supercomputing geworden., Sie wurden in weitläufige neue Hyperscale-Rechenzentren eingewebt. Sie werden immer noch von Spielern geschätzt und sind zu Beschleunigern geworden, die alle Arten von Aufgaben beschleunigen, von der Verschlüsselung über das Netzwerk bis hin zur KI.

Und sie fahren fort, Fortschritte in der Gaming-und Pro-Grafik in Workstations, Desktop-PCs und eine neue Generation von Laptops zu fahren.

Was Ist eine GPU?

Während GPUs (graphics processing unit) jetzt viel mehr sind als die PCs, auf denen sie zuerst erschienen sind, bleiben sie in einer viel älteren Idee namens Parallel Computing verankert. Und das macht GPUs so mächtig.

CPUs, um sicher zu sein, bleiben unerlässlich. Schnell und vielseitig, CPUs Rennen durch eine Reihe von Aufgaben, die viel Interaktivität erfordern. Aufrufen von Informationen von einer Festplatte als Reaktion auf Tastenanschläge des Benutzers, zum Beispiel.

Im Gegensatz dazu zerlegen GPUs komplexe Probleme in Tausende oder Millionen von separaten Aufgaben und bearbeiten sie gleichzeitig.,

Dadurch sind sie ideal für Grafiken, bei denen Texturen, Beleuchtung und das Rendern von Formen gleichzeitig ausgeführt werden müssen, damit Bilder über den Bildschirm fliegen.,v id=“bdcf9e66d4″>

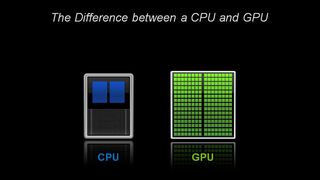

Architektonisch besteht die CPU aus nur wenigen Kernen mit viel Cache-Speicher, der einige Softwarethreads gleichzeitig verarbeiten kann., Im Gegensatz dazu besteht eine GPU aus Hunderten von Kernen, die Tausende von Threads gleichzeitig verarbeiten können.

GPUs liefern die einst esoterische Technologie des Parallel Computing. Es ist eine Technologie mit einem illustren Stammbaum, die Namen wie das Supercomputing-Genie Seymor Cray enthält. Aber anstatt die Form von riesigen Supercomputern anzunehmen, haben GPUs diese Idee auf die Desktops und Spielekonsolen von mehr als einer Milliarde Spielern übertragen.

Für GPUs, Computergrafik Erste von vielen Apps

Diese Anwendung — Computergrafik — war nur die erste von mehreren Killer-Apps., Und es treibt die riesige R&D-Engine hinter GPUs vorwärts. All dies ermöglicht es GPUs, spezialisierteren Chips mit fester Funktion, die Nischenmärkte bedienen, einen Schritt voraus zu sein.

Ein weiterer Faktor, der all diese Macht zugänglich macht: CUDA. Die 2007 erstmals veröffentlichte Parallel-Computing-Plattform ermöglicht es Programmierern, die Rechenleistung von GPUs für die allgemeine Verarbeitung zu nutzen, indem sie einige einfache Befehle in ihren Code einfügen.

Das lässt GPUs in überraschenden neuen Feldern vermehren., Und mit Unterstützung für eine schnell wachsende Anzahl von Standards — wie Kubernetes und Dockers – können Anwendungen auf einer kostengünstigen Desktop-GPU getestet und auf schnellere, anspruchsvollere Server-GPUs sowie auf alle großen Cloud-Dienstanbieter skaliert werden.

CPUs und das Ende von Moores Gesetz

Mit der Auflösung von Moores Gesetz kamen GPUs, die 1999 von NVIDIA erfunden wurden, gerade rechtzeitig.

Moores Gesetz geht davon aus, dass sich die Anzahl der Transistoren, die in eine integrierte Schaltung gestopft werden können, etwa alle zwei Jahre verdoppeln wird. Das hat jahrzehntelang zu einem rasanten Anstieg der Rechenleistung geführt., Dieses Gesetz stößt jedoch an harte körperliche Grenzen.

GPUs bieten eine Möglichkeit, Anwendungen wie Grafik, Supercomputing und KI weiter zu beschleunigen, indem Aufgaben auf viele Prozessoren aufgeteilt werden. Laut John Hennessey und David Patterson, Gewinnern des A. M. Turing Award 2017 und Autoren der Computerarchitektur: Ein quantitativer Ansatz das wegweisende Lehrbuch über Mikroprozessoren.,

GPUs: Schlüssel zu KI, Computer Vision, Supercomputing und mehr

In den letzten zehn Jahren hat sich dies als Schlüssel zu einem wachsenden Anwendungsspektrum erwiesen.

GPUs leisten viel mehr Arbeit für jede Energieeinheit als CPUs. Das macht sie zum Schlüssel für Supercomputer, die sonst die Grenzen der heutigen Stromnetze überschreiten würden.

In der KI sind GPUs der Schlüssel zu einer Technologie namens „Deep Learning“ geworden.“Deep Learning gießt große Datenmengen durch neuronale Netze und trainiert sie, um Aufgaben auszuführen, die für jeden menschlichen Codierer zu kompliziert sind.,

KI und Gaming: GPU-betriebenes Deep Learning schließt sich an

Diese Deep-Learning-Fähigkeit wird dank der Einbeziehung dedizierter Tensor-Kerne in NVIDIA-GPUs beschleunigt. Tensorkerne beschleunigen große Matrixoperationen im Herzen der KI und führen Matrixmultiplikations-und Akkumulationsberechnungen mit gemischter Präzision in einem einzigen Vorgang durch. Das beschleunigt nicht nur traditionelle KI-Aufgaben aller Art, es wird jetzt angezapft, um das Spielen zu beschleunigen.,

GPUs bieten in der Automobilindustrie viele Vorteile. Sie bieten unübertroffene Bilderkennungsfunktionen, wie Sie es erwarten würden. Sie sind aber auch der Schlüssel zur Schaffung selbstfahrender Fahrzeuge, die aus einer Vielzahl verschiedener realer Szenarien lernen und sich daran anpassen können.,

In der Robotik sind GPUs der Schlüssel, damit Maschinen ihre Umgebung wie erwartet wahrnehmen können. Ihre KI-Fähigkeiten sind jedoch der Schlüssel zu Maschinen geworden, die komplexe Aufgaben wie autonomes Navigieren erlernen können.

Im Gesundheitswesen und in den Biowissenschaften bieten GPUs viele Vorteile. Sie sind natürlich ideal für bildgebende Aufgaben. Aber GPU-basiertes deep learning beschleunigt die Analyse dieser Bilder. Sie können medizinische Daten knirschen und helfen, diese Daten durch tiefes Lernen in neue Fähigkeiten umzuwandeln.

Kurz gesagt, GPUs sind essentiell geworden. Sie begannen mit der Beschleunigung von Spielen und Grafiken., Jetzt beschleunigen sie immer mehr Bereiche, in denen die Rechenleistung einen Unterschied macht.

- AI isst Software

- AI treibt den Aufstieg des beschleunigten Rechnens in Rechenzentren voran

- Was ist der Unterschied zwischen Hardware-und Software-beschleunigtem Raytracing?

- Was Ist Max-Q?

- Was ist eine virtuelle GPU?

- Was ist der Unterschied zwischen Raytracing und Rasterisierung?,

- Was ist der Unterschied zwischen künstlicher Intelligenz, maschinellem Lernen und Deep Learning?

- Was Ist NVLink?

- Was Ist CUDA?