Nota editorului: Am actualizat postarea noastră originală despre diferențele dintre GPU-uri și procesoare, scrisă de Kevin Krewell și publicată în decembrie 2009.

CPU (central processing unit) a fost numit creierul unui PC. GPU sufletul său. În ultimul deceniu, însă, GPU-urile au ieșit din limitele boxy ale PC-ului.GPU-urile au aprins un boom AI la nivel mondial. Au devenit o parte esențială a supercalculării moderne., Au fost țesute în noi centre de date hyperscale. Încă apreciate de jucători, au devenit acceleratoare care accelerează tot felul de sarcini, de la criptare la rețea la AI.și ei continuă să conducă progrese în jocuri și grafică pro în interiorul stații de lucru, PC-uri desktop și o nouă generație de laptop-uri.

ce este un GPU?

în Timp ce Gpu (unitatea de procesare grafică) sunt acum mai mult decât Pc-uri în care au apărut prima dată, ele rămân ancorate într-un mod mult mai veche idee a sunat de calcul paralel. Și asta face GPU – urile atât de puternice.

procesoarele, pentru a fi sigur, rămân esențiale. Rapide și versatile, procesoarele trec printr-o serie de sarcini care necesită multă interactivitate. Apelarea informațiilor de pe un hard disk ca răspuns la apăsările de taste ale utilizatorului, de exemplu.în schimb, GPU-urile sparg problemele complexe în mii sau milioane de sarcini separate și le rezolvă simultan.,acest lucru le face ideale pentru grafică, unde texturile, iluminarea și redarea formelor trebuie făcute simultan pentru a menține imaginile care zboară pe ecran.,v id=”bdcf9e66d4″>

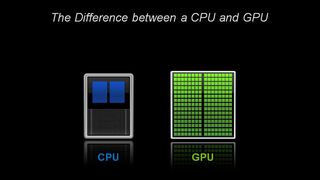

din punct de vedere Arhitectural, PROCESORUL este compus din doar câteva nuclee cu o mulțime de memorie cache, care se pot ocupa câteva programe fire la un moment dat., În schimb, un GPU este compus din sute de nuclee care pot gestiona simultan mii de fire.GPU-urile oferă tehnologia cândva ezoterică a calculului paralel. Este o tehnologie cu un pedigree ilustru care include nume precum geniul supercomputing Seymor Cray. Dar, mai degrabă decât să ia forma supercomputerelor greoaie, GPU-urile au pus această idee să funcționeze pe desktop-urile și consolele de jocuri ale mai mult de un miliard de jucători.

pentru GPU — uri, grafica pe calculator prima dintre multe aplicații

acea aplicație — grafica pe calculator-a fost doar prima dintre mai multe aplicații ucigașe., Și a condus motorul imens r&D în spatele GPU-urilor înainte. Toate acestea permit GPU-urilor să concureze înaintea cipurilor mai specializate, cu funcții fixe, care servesc piețe de nișă.un alt factor care face ca toată puterea să fie accesibilă: CUDA. Lansată pentru prima dată în 2007, platforma de calcul paralel permite codificatorilor să profite de puterea de calcul a GPU-urilor pentru procesarea de uz general, introducând câteva comenzi simple în codul lor.

asta lasă GPU-urile să prolifereze în câmpuri noi surprinzătoare., Și cu suport pentru un număr de standarde în creștere rapidă — cum ar fi Kubernetes și Dockers-aplicațiile pot fi testate pe un GPU desktop cu costuri reduse și scalate la GPU-uri de server mai rapide și mai sofisticate, precum și la fiecare furnizor important de servicii cloud.

procesoare și sfârșitul Legii lui Moore

odată cu legea lui Moore, GPU-urile, inventate de NVIDIA în 1999, au venit la timp.Legea lui Moore afirmă că numărul de tranzistori care pot fi înghesuiți într-un circuit integrat se va dubla la fiecare doi ani. Timp de decenii, aceasta a condus la o creștere rapidă a puterii de calcul., Cu toate acestea, această lege s-a confruntat cu limite fizice dure.GPU — urile oferă o modalitate de a continua accelerarea aplicațiilor — cum ar fi grafică, supercomputing și AI-prin împărțirea sarcinilor între multe procesoare. Astfel de acceleratoare sunt critice pentru viitorul semiconductori, potrivit lui John Hennessey și David Patterson, câștigătorii 2017 A. M. Turing Award și autori de Arhitectura calculatoarelor: O Abordare Cantitativă seminale manual pe microprocesoare.,

GPU-uri: cheie pentru AI, Computer Vision, Supercomputing și multe altele

în ultimul deceniu, aceasta este cheia pentru o gamă tot mai mare de aplicații.GPU-urile efectuează mult mai multă muncă pentru fiecare unitate de energie decât procesoarele. Asta le face cheie pentru supercomputere care altfel ar depăși limitele rețelelor electrice de astăzi.

În ai, GPU-urile au devenit cheia unei tehnologii numite „învățare profundă.”Învățarea profundă toarnă cantități mari de date prin rețele neuronale, antrenându-le pentru a îndeplini sarcini prea complicate pentru a descrie orice coder uman.,

AI și jocuri: învățarea profundă bazată pe GPU vine în cerc complet

că capacitatea de învățare profundă este accelerată datorită includerii nucleelor Tensor dedicate în GPU-urile NVIDIA. Nucleele Tensor accelerează operațiile matricei mari, în centrul AI, și efectuează calcule de multiplicare și acumulare a matricei de precizie mixtă într-o singură operație. Acest lucru nu numai că accelerează sarcinile tradiționale AI de tot felul, dar acum este exploatat pentru a accelera jocurile.,

în industria auto, GPU-urile oferă multe beneficii. Acestea oferă capabilități de recunoaștere a imaginilor de neegalat, așa cum v-ați aștepta. Dar ele sunt, de asemenea, esențiale pentru crearea de autovehicule capabile să învețe și să se adapteze la un număr mare de scenarii diferite din lumea reală.,în robotică, GPU – urile sunt esențiale pentru a permite mașinilor să perceapă mediul lor, așa cum v-ați aștepta. Cu toate acestea, capacitățile lor AI au devenit esențiale pentru mașinile care pot învăța sarcini complexe, cum ar fi navigarea autonomă.în domeniul sănătății și al științelor vieții, GPU-urile oferă multe beneficii. Sunt ideale pentru sarcini imagistice, desigur. Dar învățarea profundă bazată pe GPU accelerează analiza acestor imagini. Ele pot crunch date medicale și de a ajuta transforma aceste date, prin învățare profundă, în noi capacități.pe scurt, GPU-urile au devenit esențiale. Au început prin accelerarea jocurilor și graficii., Acum accelerează din ce în ce mai multe zone în care puterea de calcul va face diferența.

- AI Este Consumul de Software

- AI Conduce la Creșterea Accelerată Calcul în Centre de Date

- care este Diferența Dintre Hardware și Software Accelerat Ray Tracing?

- ce este Max-Q?

- ce este un GPU Virtual?

- care este diferența dintre Ray Tracing și rasterizare?,

- care este diferența dintre inteligența artificială, învățarea automată și învățarea profundă?

- ce este NVLink?

- ce este CUDA?