Uwaga redaktora: zaktualizowaliśmy nasz oryginalny post na temat różnic między GPU i procesorów, którego autorem jest Kevin Krewell, i opublikowany w grudniu 2009 roku.

procesor (jednostka centralna) został nazwany mózgiem komputera. GPU jego dusza. W ciągu ostatniej dekady, jednak, procesory graficzne zostały zerwane z Boxy ograniczeń komputera.

GPU wywołały światowy boom na si. Stały się kluczowym elementem współczesnego superkomputera., Zostały wplecione w nowe hiperskalowe centra danych. Wciąż cenione przez graczy, stały się akceleratorami przyspieszającymi wszelkiego rodzaju zadania, od szyfrowania przez sieć po sztuczną inteligencję.

i nadal napędzają postępy w grach i profesjonalnej grafice na stacjach roboczych, komputerach stacjonarnych i laptopach nowej generacji.

Co To jest GPU?

podczas gdy GPU (graphics processing unit) są teraz o wiele więcej niż komputery, w których pojawiły się po raz pierwszy, pozostają zakotwiczone w znacznie starszym pomyśle o nazwie parallel computing. To właśnie sprawia, że procesory GPU są tak potężne.

procesory, dla pewności, pozostają niezbędne. Szybkie i wszechstronne Procesory ścigają się przez serię zadań wymagających dużej interaktywności. Na przykład wywołanie informacji z dysku twardego w odpowiedzi na naciśnięcia klawiszy użytkownika.

natomiast układy GPU dzielą złożone problemy na tysiące lub miliony oddzielnych zadań i rozwiązują je jednocześnie.,

to sprawia, że są idealne do grafiki, gdzie tekstury, oświetlenie i renderowanie kształtów muszą być wykonane na raz, aby obrazy latały po ekranie.,v id=”bdcf9e66d4″>

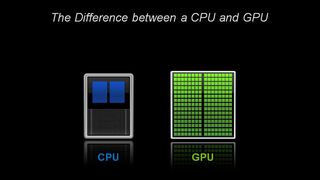

architektonicznie procesor składa się z zaledwie kilku rdzeni z dużą ilością pamięci podręcznej pamięć, która może obsługiwać kilka wątków oprogramowania na raz., Natomiast procesor graficzny składa się z setek rdzeni, które mogą obsługiwać tysiące wątków jednocześnie.

GPU dostarczają niegdyś ezoteryczną technologię obliczeń równoległych. To technologia o wybitnym rodowodzie, która zawiera takie nazwiska jak geniusz superkomputerowy Seymor Cray. Ale zamiast przybrać kształt ogromnych superkomputerów, GPU umieścić ten pomysł do pracy na komputerach stacjonarnych i konsolach do gier ponad miliard graczy.

dla GPU Grafika komputerowa pierwsza z wielu aplikacji

Ta aplikacja — Grafika komputerowa — była tylko pierwszą z kilku zabójczych aplikacji., I napędza ogromny silnik R& d za GPU do przodu. Wszystko to pozwala GPU ścigać się przed bardziej wyspecjalizowanymi układami o stałej funkcji obsługującymi niszowe rynki.

kolejny czynnik sprawiający, że cała ta moc jest dostępna: CUDA. Po raz pierwszy wydana w 2007 roku, platforma obliczeniowa parallel pozwala programistom wykorzystać moc obliczeniową GPU do przetwarzania ogólnego, wstawiając kilka prostych poleceń do swojego kodu.

To pozwala GPU rozmnażać się w zaskakujących nowych dziedzinach., Dzięki obsłudze szybko rosnącej liczby standardów, takich jak Kubernetes i Docker, aplikacje mogą być testowane na tanim komputerowym GPU i skalowane do szybszych, bardziej zaawansowanych serwerowych procesorów graficznych, a także każdego głównego dostawcy usług w chmurze.

procesory i koniec prawa Moore’a

wraz z likwidacją prawa Moore' a, procesory graficzne, wynalezione przez Nvidię w 1999 roku, pojawiły się w samą porę.

Prawo Moore ' a zakłada, że liczba tranzystorów, które mogą być zapchane do układu scalonego, podwoi się co dwa lata. Od dziesięcioleci napędza to szybki wzrost mocy obliczeniowej., Prawo to jednak znalazło się w trudnej sytuacji fizycznej.

GPU oferuje sposób na dalsze przyspieszanie aplikacji-takich jak grafika, superkomputery i sztuczna inteligencja – poprzez dzielenie zadań między wiele procesorów. Takie akceleratory mają kluczowe znaczenie dla przyszłości półprzewodników, według Johna Hennesseya i Davida Pattersona, laureatów Nagrody Turinga 2017 A. M. oraz autorów Computer Architecture: a Quantitative Approach the seminal textbook on microprocessors.,

GPU: klucz do sztucznej inteligencji, wizji komputerowej, superkomputerów i innych

w ciągu ostatniej dekady okazało się to kluczem do rosnącej gamy zastosowań.

procesory graficzne wykonują znacznie więcej pracy dla każdej jednostki energii niż procesory. To czyni je kluczowymi dla superkomputerów, które w przeciwnym razie przekroczyłyby granice dzisiejszych sieci elektrycznych.

w sztucznej inteligencji Karty graficzne stały się kluczem do technologii zwanej „deep learning.”Głębokie uczenie przelewa ogromne ilości danych przez sieci neuronowe, szkoląc je w wykonywaniu zadań zbyt skomplikowanych, aby każdy programista mógł je opisać.,

AI i granie: uczenie głębokie oparte na GPU jest pełne kręgu

zdolność uczenia głębokiego jest przyspieszana dzięki zastosowaniu dedykowanych rdzeni Tensorowych w układach GPU NVIDIA. Rdzenie tensorowe przyspieszają operacje dużych macierzy, będące sercem sztucznej inteligencji, i wykonują obliczenia mnożenia i akumulowania macierzy o mieszanej precyzji w ramach jednej operacji. To nie tylko przyspiesza tradycyjne zadania AI wszelkiego rodzaju, ale jest teraz wykorzystywane, aby przyspieszyć granie.,

w przemyśle motoryzacyjnym układy GPU oferują wiele korzyści. Zapewniają niezrównane możliwości rozpoznawania obrazu, jak można się spodziewać. Ale są również kluczem do tworzenia pojazdów samojezdnych, które mogą uczyć się i dostosowywać do ogromnej liczby różnych rzeczywistych scenariuszy.,

w robotyce układy GPU są kluczem do umożliwienia maszynom postrzegania ich środowiska, jak można się spodziewać. Ich możliwości sztucznej inteligencji stały się jednak kluczowe dla maszyn, które mogą uczyć się złożonych zadań, takich jak nawigacja autonomiczna.

w opiece zdrowotnej i naukach przyrodniczych GPU oferują wiele korzyści. Są idealne do zadań obrazowania, oczywiście. Ale głębokie uczenie oparte na GPU przyspiesza analizę tych obrazów. Mogą one gromadzić dane medyczne i pomóc przekształcić te dane, poprzez głębokie uczenie się, w nowe możliwości.

W skrócie, GPU stały się niezbędne. Zaczęli od przyspieszenia gier i Grafiki., Teraz przyspieszają coraz więcej obszarów, w których liczenie mocy obliczeniowej będzie miało znaczenie.

- AI zjada oprogramowanie

- AI napędza rozwój przyspieszonych obliczeń w centrach danych

- Jaka jest różnica między sprzętowym i programowym przyspieszonym Ray Tracingiem?

- Co To jest Max-Q?

- Co To jest wirtualny GPU?

- Jaka jest różnica między Ray Tracingiem a Rasteryzacją?,

- Jaka jest różnica między Sztuczną Inteligencją, uczeniem maszynowym i uczeniem głębokim?

- Co To jest NVLink?

- Co To jest CUDA?