Editor ‘s note: We’ ve updated our original post on the differences between GPU and CPU, authored by Kevin Krewell, and published in December 2009.

A CPU-t (központi feldolgozó egység) PC agyának nevezték. A GPU lelke. Az elmúlt évtizedben azonban a GPU-k kitörtek a számítógép dobozos határain.

a GPU-k világméretű AI-boomot gyújtottak fel. A modern szuperszámítógépek kulcsfontosságú részévé váltak., Ők már szőtt burjánzó új hiperskála adatközpontok. A játékosok még mindig nagyra értékelik őket, gyorsítókká váltak, felgyorsítva mindenféle feladatot a titkosítástól a hálózatépítésig az AI-ig.

és továbbra is a munkaállomásokon, az asztali PC-ken és a laptopok új generációján belül vezetik a játék-és pro grafikus fejlesztéseket.

mi a GPU?

míg a GPU-k (grafikus feldolgozó egység) sokkal többről szólnak, mint azok a PC-k, amelyekben először megjelentek, egy sokkal régebbi, párhuzamos számítástechnikának nevezett ötletben vannak rögzítve. És ez teszi a GPU-kat olyan erőssé.

A CPU-k biztosan nélkülözhetetlenek maradnak. A gyors és sokoldalú CPU-k egy sor olyan feladaton keresztül versenyeznek, amelyek sok interaktivitást igényelnek. A merevlemezről származó információk felhívása például a felhasználó billentyűleütéseire adott válaszként.

ezzel szemben a GPU-k több ezer vagy több millió különálló feladatra bontják a komplex problémákat, és egyszerre dolgozzák ki azokat.,

Ez ideálissá teszi őket a grafikákhoz, ahol a textúrákat, a világítást és az alakzatok megjelenítését egyszerre kell elvégezni, hogy a képek a képernyőn repüljenek.,v id=”bdcf9e66d4″>

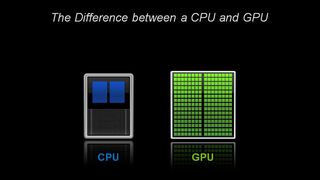

Építészetileg, a CPU áll, csak néhány magot, sok cache-memória, amely képes kezelni néhány szoftver szálak egy időben., Ezzel szemben a GPU több száz magból áll, amelyek egyszerre több ezer szálat tudnak kezelni.

a GPU-k a párhuzamos számítástechnika ezoterikus technológiáját szolgáltatják. Ez egy kiváló törzskönyvű technológia, amely olyan neveket tartalmaz, mint a szuperszámítógépes zseni, Seymor Cray. De ahelyett, hogy a formáját Hulk szuperszámítógépek, GPU tenni ezt az elképzelést, hogy a munka az asztali, játékkonzolok több mint egy milliárd játékos.

GPU-k esetében a számítógépes grafika először a sok alkalmazás közül

Ez az alkalmazás — számítógépes grafika-csak az első volt a több gyilkos alkalmazás közül., A hatalmas R&D motort a GPU-k mögött előre hajtotta. Mindez lehetővé teszi a GPU-k számára, hogy versenyezzenek a speciálisabb, fix funkciós chipek előtt, amelyek niche piacokat szolgálnak fel.

egy másik tényező, amely az összes energiát elérhetővé teszi: CUDA. Először 2007-ben jelent meg, a párhuzamos számítási platform lehetővé teszi a kódolók számára, hogy kihasználják a GPU-k számítási teljesítményét általános célú feldolgozáshoz, néhány egyszerű parancs beillesztésével a kódjukba.

Ez hagyja GPU szaporodnak meglepő új területeken., A gyorsan növekvő számú szabvány-például a Kubernetes vagy a Dockers — támogatása mellett az alkalmazások alacsony költségű asztali GPU — n is tesztelhetők, és gyorsabb, kifinomultabb szerver GPU-kra, valamint minden nagyobb felhőszolgáltatóra méretezhetők.

CPU-k és Moore törvényének vége

Moore törvényének megszűnésével az NVIDIA által 1999-ben feltalált GPU-k éppen időben érkeztek.

Moore törvénye kimondja, hogy az integrált áramkörbe tömöríthető tranzisztorok száma körülbelül kétévente megduplázódik. Évtizedek óta ez hajtja a számítási teljesítmény gyors növekedését., Ez a törvény azonban kemény fizikai korlátokkal szembesült.

a GPU — k lehetőséget kínálnak az alkalmazások — például a grafika, a szuperszámítógép és az AI-gyorsításának folytatására a feladatok sok processzor közötti elosztásával. Az ilyen gyorsítók kritikusak a félvezetők jövője szempontjából John Hennessey és David Patterson, a 2017-es Turing-díj nyertesei és a számítógépes architektúra szerzői szerint: kvantitatív megközelítés a mikroprocesszorokról szóló szeminárium.,

GPU: Key to AI, Computer Vision, Supercomputing and More

az elmúlt évtizedben ez bizonyított kulcsa a növekvő alkalmazási körnek.

a GPU-k sokkal több munkát végeznek minden energiaegységben, mint a CPU-k. Ez kulcsfontosságúvá teszi őket a szuperszámítógépek számára, amelyek egyébként túllépnék a mai elektromos hálózatok határait.

az AI-ben a GPU-k kulcsfontosságúvá váltak a “mély tanulás” nevű technológia számára.”A mély tanulás hatalmas mennyiségű adatot tölt be neurális hálózatokon keresztül, kiképezve őket olyan feladatok elvégzésére, amelyek túl bonyolultak ahhoz, hogy bármely emberi kódoló leírhassa.,

AI and Gaming: GPU-meghajtású mély tanulás jön teljes kör

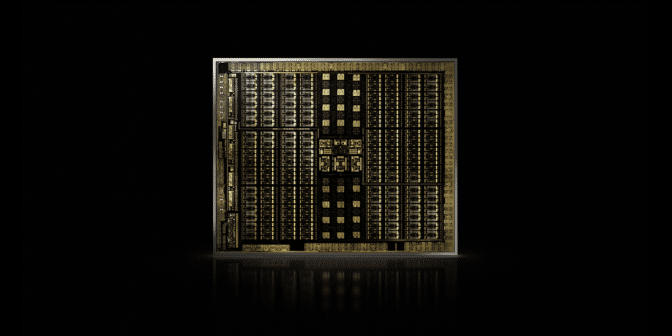

hogy a mély tanulási képesség felgyorsul, köszönhetően a felvétel dedikált Tensor magok NVIDIA GPU. A tenzormagok felgyorsítják a nagy mátrixműveleteket, az AI középpontjában, és egy művelet során vegyes pontosságú mátrixszaporítási és-felhalmozódási számításokat végeznek. Ez nem csak felgyorsítja a hagyományos AI feladatok mindenféle, ez most is megérintette, hogy gyorsítsa fel a játék.,

az autóiparban a GPU-k számos előnnyel járnak. Páratlan képfelismerési képességeket biztosítanak, ahogy az elvárható lenne. De kulcsfontosságúak ahhoz is, hogy olyan önvezető járműveket hozzanak létre, amelyek képesek tanulni-és alkalmazkodni — számos különböző valós forgatókönyvhöz.,

a robotikában a GPU-k kulcsfontosságúak ahhoz, hogy a gépek érzékeljék környezetüket, ahogy az elvárható lenne. AI képességeik azonban kulcsfontosságúvá váltak olyan gépek számára, amelyek összetett feladatokat tanulhatnak, például önállóan navigálhatnak.

az egészségügyben és az élettudományokban a GPU-k számos előnnyel járnak. Természetesen ideálisak képalkotó feladatokhoz. De a GPU-alapú mély tanulás felgyorsítja ezeknek a képeknek az elemzését. Orvosi adatokat gyűjthetnek össze, és mély tanulással új képességekké alakíthatják ezeket az adatokat.röviden: a GPU-k elengedhetetlenné váltak. A játék és a grafika felgyorsításával kezdték., Most egyre több olyan területet gyorsítanak fel, ahol a számítási teljesítmény változást hoz.

- AI is Eating Software

- AI drivs The Rise of Accelerated Computing in Data Centers

- mi a különbség a hardver és a szoftver gyorsított Sugárkövetése között?

- mi a Max-Q?

- mi a virtuális GPU?

- mi a különbség a sugárkövetés és a Raszterezés között?,

- mi a különbség a mesterséges intelligencia, a gépi tanulás és a mély tanulás között?

- mi az NVLink?

- mi az a CUDA?