Quels sont les Bots

un bot Internet est une application logicielle qui exécute des tâches automatisées sur internet. Les tâches exécutées par les robots sont généralement simples et exécutées à un rythme beaucoup plus élevé que l’activité humaine sur Internet.

certains bots sont légitimes—par exemple, Googlebot est une application utilisée par Google pour explorer Internet et l’indexer pour la recherche. D’autres robots sont malveillants—par exemple, les robots utilisés pour analyser automatiquement les sites web à la recherche de vulnérabilités logicielles et exécuter des modèles d’attaque simples.,

qu’Est Ce qu’un Botnet

Il existe de nombreux types de logiciels malveillants qui infectent les périphériques des utilisateurs finaux, avec l’objectif de les enrôler dans un botnet. Tout périphérique infecté commence à communiquer avec un centre de commande et de contrôle (C&C) et peut effectuer des activités automatisées sous le contrôle central de l’attaquant.

de nombreux acteurs de la menace sont activement engagés dans la construction de botnets massifs, les plus grands couvrant des millions d’ordinateurs., Souvent, le botnet peut se développer lui-même, par exemple en utilisant des appareils infectés pour envoyer des spams, ce qui peut infecter plus de machines.

les propriétaires de Botnet les utilisent pour des activités malveillantes à grande échelle, généralement des attaques par déni de Service distribué (DDoS). Les Botnets peuvent également être utilisés pour toute autre activité de bot malveillant, tels que les robots de spam ou les robots sociaux (décrits ci-dessous), bien qu’à une échelle beaucoup plus grande.

Types de Bots

Il existe de nombreux types de bots actifs sur Internet, à la fois légitimes et malveillants. Vous trouverez ci-dessous plusieurs exemples courants.,

Spider Bots

Les Spider bots, également appelés web spiders ou crawlers, naviguent sur le web en suivant des hyperliens, dans le but de récupérer et d’indexer du contenu web. Les araignées téléchargent du HTML et d’autres ressources, telles que CSS, JavaScript et images, et les utilisent pour traiter le contenu du site.

Si vous avez un grand nombre de pages web, vous pouvez placer un robots.fichier TXT à la racine de votre serveur web, et fournir des instructions aux robots, en spécifiant quelles parties de votre site ils peuvent explorer, et à quelle fréquence.,

Scraper Bots

Les Scrapers sont des robots qui lisent les données des sites Web dans le but de les enregistrer hors ligne et de permettre leur réutilisation. Cela peut prendre la forme de gratter l’intégralité du contenu des pages web ou de gratter le contenu web pour obtenir des points de données spécifiques, tels que les noms et les prix des produits sur les sites de commerce électronique.

le grattage Web est une zone grise-dans certains cas, le grattage est légitime et peut être autorisé par les propriétaires de sites web. Dans d’autres cas, les opérateurs de bots peuvent violer les conditions d’utilisation du site web ou, pire, utiliser le grattage pour voler du contenu sensible ou protégé par des droits d’auteur.,

Spam Bots

un spambot est une application Internet conçue pour recueillir des adresses e-mail pour les listes de diffusion de spam. Un robot anti-spam peut collecter des e-mails provenant de sites Web, de sites Web de médias sociaux, d’entreprises et d’organisations, en tirant parti du format distinctif des adresses e-mail.

Après que les attaquants ont amassé une grande liste d’adresses e—mail, ils peuvent les utiliser non seulement pour envoyer des spams, mais aussi à d’autres fins néfastes:

- credential cracking-appariement des e-mails avec des mots de passe communs pour obtenir un accès non autorisé aux comptes.,

- form spam-insertion automatique de spams, tels que des publicités ou des liens de logiciels malveillants, dans des formulaires sur des sites Web populaires, généralement des formulaires de commentaires ou de commentaires.

outre les dommages directs causés aux utilisateurs finaux et aux organisations touchées par les campagnes de spam, les robots de spam peuvent également étouffer la bande passante du serveur et augmenter les coûts pour les fournisseurs de services Internet (FAI).

robots de médias sociaux

Les robots sont exploités sur les réseaux sociaux et utilisés pour générer automatiquement des messages, défendre des idées, agir en tant que suiveur des utilisateurs et en tant que faux comptes pour gagner eux-mêmes des abonnés., On estime que 9 à 15% des comptes Twitter sont des robots sociaux.

les robots sociaux peuvent être utilisés pour infiltrer des groupes de personnes et pour propager des idées spécifiques. Comme il n’y a pas de réglementation stricte régissant leur activité, les robots sociaux jouent un rôle majeur dans l’opinion publique en ligne.

les robots sociaux peuvent créer de faux comptes (bien que cela devienne plus difficile à mesure que les réseaux sociaux deviennent plus sophistiqués), amplifier le message de l’opérateur de bot et générer de faux followers / likes., Il est difficile d’identifier et d’atténuer les robots sociaux, car ils peuvent présenter un comportement très similaire à celui des utilisateurs réels.

Télécharger les Bots

Télécharger les bots sont des programmes automatisés qui peuvent être utilisés pour télécharger automatiquement les logiciels ou applications mobiles. Ils peuvent être utilisés pour influencer les statistiques de téléchargement, par exemple pour gagner plus de téléchargements sur les magasins d’applications populaires et aider les nouvelles applications à atteindre le sommet des graphiques. Ils peuvent également être utilisés pour attaquer des sites de téléchargement, créant de faux téléchargements dans le cadre d’une attaque par déni de Service (DoS) de la couche application.,

Ticketing Bots

Les Ticketing Bots sont un moyen automatisé d’acheter des billets pour des événements populaires, dans le but de revendre ces billets pour un profit. Cette activité est illégale dans de nombreux pays, et même si elle n’est pas interdite par la loi, elle agace les organisateurs d’événements, les vendeurs de billets et les consommateurs.

Les robots de billetterie ont tendance à être très sophistiqués, imitant les mêmes comportements que les acheteurs de billets humains. Dans de nombreux domaines de la billetterie, la proportion de billets achetés par des robots automatisés varie entre 40 et 95%.,

Comment détecter le trafic de bots dans L’analyse Web

Voici quelques paramètres que vous pouvez utiliser lors d’une vérification manuelle de votre analyse Web, pour détecter le trafic de bots sur un site web:

- tendances du trafic—des pics anormaux de trafic peuvent indiquer que des bots Cela est particulièrement vrai si le trafic se produit pendant les heures impaires.

- taux de rebond-des hauts ou des bas anormaux peuvent être le signe de mauvais robots. Par exemple, les bots qui atteignent une page spécifique sur le site, puis qui changent D’adresse IP, semblent avoir un rebond à 100%.,

- sources de trafic – lors d’une attaque malveillante, le canal principal qui envoie le trafic est le trafic « direct” et le trafic sera constitué de nouveaux utilisateurs et de nouvelles sessions.

- les performances du Serveur—un ralentissement des performances du serveur peut être un signe de bots.

- adresses IP / géolocalisation suspectes-augmentation de l’activité vers une plage D’adresses IP inconnue ou une région dans laquelle vous ne faites pas d’affaires.

visites suspectes D’une seule adresse IP—un grand nombre de visites d’une seule adresse IP. Les humains demandent généralement quelques pages et pas d’autres, alors que les robots demandent souvent toutes les pages., - sources linguistiques-voir les accès provenant d’autres langues que vos clients n’utilisent généralement pas.

Tout ce qui précède ne sont que des indicateurs approximatifs de l’activité du bot. Sachez que des robots malveillants sophistiqués peuvent générer une signature réaliste, semblable à celle d’un utilisateur, dans votre analyse web. Il est conseillé d’utiliser une solution de gestion de bot dédiée qui offre une visibilité complète du trafic de bot.

Comment arrêter le trafic de bots: mesures D’atténuation de base

Il existe quelques mesures simples que vous pouvez prendre pour bloquer au moins certains bots et réduire votre exposition aux mauvais bots:

- placez des robots.,txt à la racine de votre site web pour définir les robots sont autorisés à accéder à votre site web. Gardez à l’esprit que cela n’est efficace que pour gérer les modèles d’exploration des bots légitimes et ne protège pas contre les activités malveillantes des bots.

- ajoutez des formulaires d’inscription, de commentaire ou de téléchargement. De nombreux éditeurs et sites Web premium placent pour empêcher les robots de téléchargement ou de spam.

- définissez une alerte JavaScript pour vous avertir du trafic de bot. Avoir JavaScript contextuel en place peut agir comme un buzzer et vous alerter chaque fois qu’il voit un bot ou un élément similaire entrer dans un site web.,

comment les robots échappent-ils à la détection?

La technologie des robots a évolué au cours de la dernière décennie. À l’origine, les bots étaient un script frappant un site web pour récupérer des données ou effectuer des actions. Ces scripts n’acceptaient pas les cookies et n’analysaient pas JavaScript, ce qui les rendait très faciles à détecter.

Au fil du temps, les bots sont devenus plus sophistiqués, acceptant les cookies et analysant JavaScript, mais ils pouvaient toujours être détectés assez facilement car ils utilisaient moins les éléments dynamiques du site Web que les utilisateurs humains.,

la prochaine évolution a été l’utilisation de navigateurs sans tête comme PhantomJS—ceux-ci peuvent traiter le contenu du site Web dans son intégralité. Bien que ces navigateurs soient plus sophistiqués que les robots de base, les navigateurs sans tête ne peuvent toujours pas effectuer toutes les actions que les utilisateurs réels peuvent.

les types de robots Les plus avancés sont basés sur le navigateur Chrome et sont presque impossibles à distinguer des utilisateurs réels. Ces robots simulent même une activité humaine telle que le clic sur des éléments de la page.

techniques avancées d’atténuation des robots

Au fur et à mesure de l’évolution des robots, Les techniques d’atténuation ont évolué., Il existe actuellement trois approches techniques pour détecter et atténuer les mauvais bots:

- approche statique—les outils d’analyse statique peuvent identifier les requêtes web et les informations d’en-tête corrélées avec les mauvais bots, déterminer passivement l’identité du bot et le bloquer si nécessaire.

- approche par défi – vous pouvez équiper votre site Web de la possibilité de vérifier de manière proactive si le trafic provient d’utilisateurs humains ou de robots. Les détecteurs de bots basés sur des défis peuvent vérifier la capacité de chaque visiteur à utiliser des cookies, à exécuter JavaScript et à interagir avec des éléments., Une capacité réduite à traiter ces types d’éléments est un signe de trafic de bot.

- approche comportementale – un mécanisme d’atténuation des robots comportementaux examine la signature comportementale de chaque visiteur pour voir si c’est ce qu’il prétend être. L’atténuation des robots comportementaux établit une ligne de base du comportement normal pour les agents utilisateurs tels que Google Chrome, et voit si l’utilisateur actuel s’écarte de ce comportement. Il peut également comparer les signatures comportementales aux signatures connues précédentes de mauvais bots.,

en combinant les trois approches, vous pouvez surmonter les robots évasifs de tous types et les séparer avec succès du trafic humain. Vous pouvez utiliser ces approches indépendamment ou vous pouvez compter sur les services d’atténuation de bot pour exécuter des techniques pour vous.

Les services d’atténuation des bots sont des outils automatisés qui utilisent les méthodes ci-dessus pour identifier les bots. Ces services peuvent être utilisés pour surveiller le trafic API et détecter s’il s’agit d’un trafic machine légitime ou de mauvais robots « trayant” votre API.,

Les services avancés d’atténuation des bots utilisent la limitation du débit pour chaque client ou machine demandeur, au lieu d’une adresse IP entière, ce qui lui permet de limiter l’exploration des mauvais bots. Une fois qu’un bot est identifié, ces services peuvent propager les informations sur le réseau, pour s’assurer que le même bot ne peut plus accéder à votre site ou à votre API.

de Voir comment Imperva Bot de Gestion peut vous aider avec les menaces automatisées.,

Imperva Bot Management

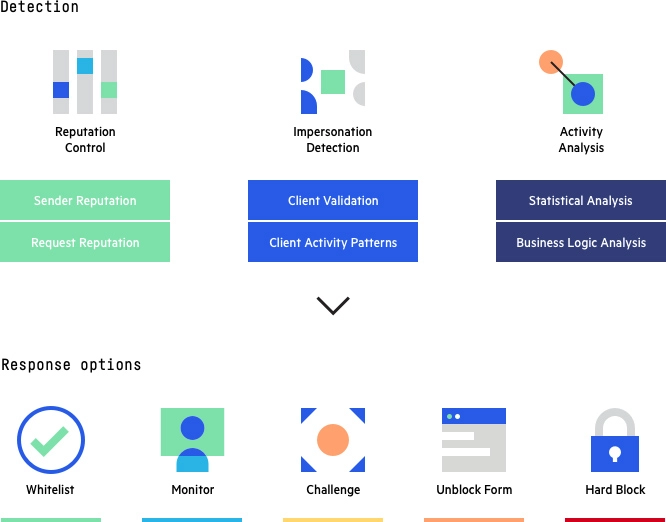

La solution de gestion de bot d’Imperva utilise les trois approches décrites ci—dessus-statique, basée sur les défis et basée sur le comportement-pour enquêter sur chaque visiteur de votre site, humain ou non, et le faire correspondre avec un identifiant comportemental. Il peut protéger efficacement contre les robots malveillants tout en garantissant que les robots légitimes et les utilisateurs humains ont un accès ininterrompu à votre site.,

Imperva Bot Management: méthodes de détection et options de réponse

en plus d’aider à atténuer les mauvaises activités de bot, Imperva fournit une protection multicouche pour s’assurer que les sites Web et les applications sont disponibles, facilement accessibles et sûrs. La solution de sécurité des applications Imperva comprend:

- API security-protège les API contre les robots et les attaquants humains en veillant à ce que seul le trafic souhaité puisse accéder à votre point de terminaison API, ainsi qu’en détectant et en bloquant les exploits des vulnérabilités.,

- Protection DDoS-maintenir la disponibilité dans toutes les situations. Empêchez tout type d’attaque DDoS, quelle que soit sa taille, d’empêcher l’accès à votre site web et à votre infrastructure réseau.

- CDN-améliorez les performances du site web et réduisez les coûts de bande passante avec un CDN conçu pour les développeurs. Mettez en Cache les ressources statiques à la périphérie tout en accélérant les API et les sites Web dynamiques.

- pare—feu D’Application Web-permet le trafic légitime et empêche le mauvais trafic. Protégez vos applications à la périphérie avec un WAF cloud de classe entreprise.,

- râpe-Protégez vos applications de l’intérieur contre les attaques connues et zero-day. Protection rapide et précise sans signature ni Mode d’apprentissage.

- Account Takeover Protection-utilise un processus de détection basé sur l’intention pour identifier et se défendre contre les tentatives de reprise des comptes des utilisateurs à des fins malveillantes.