Qué son Bots

Un bot de Internet es una aplicación de software que ejecuta tareas automatizadas a través de internet. Las tareas ejecutadas por los bots suelen ser simples y se realizan a un ritmo mucho más alto en comparación con la actividad humana en Internet.

algunos bots son legítimos, por ejemplo, Googlebot es una aplicación utilizada por Google para rastrear Internet e indexarla para realizar búsquedas. Otros bots son maliciosos, por ejemplo, los bots utilizados para escanear automáticamente sitios web en busca de vulnerabilidades de software y ejecutar patrones de ataque simples.,

Qué es una Botnet

hay muchos tipos de malware que infectan los dispositivos de los usuarios finales, con el objetivo de alistarlos en una botnet. Cualquier dispositivo que se infecte comienza a comunicarse con un centro de comando y Control (C& C) y puede realizar actividades automatizadas bajo el control central del atacante.

muchos actores de amenazas participan activamente en la construcción de botnets masivos, con los más grandes que abarcan millones de computadoras., A menudo, la botnet puede crecer por sí misma, por ejemplo, mediante el uso de dispositivos infectados para enviar correos electrónicos no deseados, que pueden infectar a más máquinas.

los propietarios de botnets los utilizan para actividades maliciosas a gran escala, ataques de denegación de servicio (DDoS) comúnmente distribuidos. Las Botnets también se pueden usar para cualquier otra actividad de bots maliciosos, como bots de spam o bots sociales (descritos a continuación), aunque a una escala mucho mayor.

Tipos de Bots

Hay muchos tipos de bots activos en Internet, tanto legítimos y malicioso. A continuación se presentan varios ejemplos comunes.,

Spider Bots

Spider bots, también conocidos como web spiders o crawlers, navegan por la web siguiendo hipervínculos, con el objetivo de recuperar e indexar contenido web. Las arañas descargan HTML y otros recursos, como CSS, JavaScript e imágenes, y los utilizan para procesar el contenido del sitio.

Si tiene un gran número de páginas web, puede colocar un robot.txt archivo en la raíz de su servidor web, y proporcionar instrucciones a los bots, especificando qué partes de su sitio pueden rastrear, y con qué frecuencia.,

Scraper Bots

Los Scraper son bots que leen datos de sitios web con el objetivo de guardarlos offline y permitir su reutilización. Esto puede tomar la forma de raspar todo el contenido de las páginas web o raspar el contenido web para obtener puntos de datos específicos, como nombres y precios de productos en sitios de comercio electrónico.

el raspado Web es un área gris -en algunos casos, el raspado es legítimo y puede ser permitido por los propietarios del sitio web. En otros casos, los operadores de bots pueden estar violando los Términos de uso del sitio web o, lo que es peor, aprovechar el raspado para robar contenido sensible o con derechos de autor.,

robots de Spam

un spambot es una aplicación de Internet diseñada para recopilar direcciones de correo electrónico para listas de correo no deseado. Un bot de spam puede recopilar correos electrónicos de sitios web, sitios web de redes sociales, empresas y organizaciones, aprovechando el formato distintivo de las direcciones de correo electrónico.

después de que los atacantes hayan acumulado una gran lista de direcciones de correo electrónico, pueden utilizarlas no solo para enviar correos electrónicos no deseados, sino también para otros fines nefastos:

- Cracking de credenciales: emparejar correos electrónicos con contraseñas comunes para obtener acceso no autorizado a las cuentas.,

- spam de formularios: inserta automáticamente spam, como anuncios o enlaces de malware, en formularios de sitios web populares, generalmente formularios de comentarios o comentarios.

además del daño directo causado a los usuarios finales y las organizaciones afectadas por las campañas de spam, los robots de spam también pueden asfixiar el ancho de banda del servidor y aumentar los costos para los proveedores de servicios de Internet (ISP).

bots de redes sociales

los Bots se operan en redes sociales y se utilizan para generar automáticamente mensajes, promover ideas, actuar como seguidores de los usuarios y como cuentas falsas para ganar seguidores ellos mismos., Se estima que el 9-15% de las cuentas de Twitter son bots sociales.

los bots sociales se pueden utilizar para infiltrarse en grupos de personas y propagar ideas específicas. Dado que no hay una regulación estricta que rija su actividad, los bots sociales juegan un papel importante en la opinión pública en línea.

los bots sociales pueden crear cuentas falsas (aunque esto es cada vez más difícil a medida que las redes sociales se vuelven más sofisticadas), amplificar el mensaje del operador del bot y generar seguidores/me gusta falsos., Es difícil identificar y mitigar los bots sociales, porque pueden exhibir un comportamiento muy similar al de los usuarios reales.

bots de descarga

los bots de descarga son programas automatizados que se pueden utilizar para descargar automáticamente software o aplicaciones móviles. Se pueden usar para influir en las estadísticas de descarga, por ejemplo, para obtener más descargas en tiendas de aplicaciones populares y ayudar a que las nuevas aplicaciones lleguen a la cima de las listas. También se pueden usar para atacar sitios de descarga, creando descargas falsas como parte de un ataque de denegación de Servicio (DoS) de la capa de aplicación.,

bots de venta de entradas

los Bots de venta de entradas son una forma automatizada de comprar entradas para eventos populares, con el objetivo de revender esas entradas con un beneficio. Esta actividad es ilegal en muchos países, e incluso si no está prohibida por la ley, es una molestia para los organizadores de eventos, vendedores de entradas y consumidores.

los bots de venta de entradas tienden a ser muy sofisticados, emulando los mismos comportamientos que los compradores de entradas humanos. En muchos dominios de venta de entradas, la proporción de entradas compradas por bots automatizados oscila entre el 40-95%.,

cómo detectar el tráfico de bots en el análisis web

Los siguientes son algunos parámetros que puede usar en una comprobación manual de su análisis web, para detectar el tráfico de bots que llega a un sitio web:

- tendencias de tráfico: los picos anormales en el tráfico pueden indicar que los bots llegan al sitio. Esto es particularmente cierto si el tráfico ocurre durante horas impares.

- tasa de rebote: los máximos o mínimos anormales pueden ser un signo de bots malos. Por ejemplo, los bots que llegan a una página específica del sitio y luego cambian de IP parecerán tener un rebote del 100%.,

- Fuentes de tráfico-durante un ataque malicioso, el canal principal que envía tráfico es el tráfico «directo» y el tráfico consistirá en nuevos usuarios y sesiones.

- rendimiento del Servidor: una desaceleración en el rendimiento del servidor puede ser un signo de bots.

- IPS/geolocalizaciones sospechosas: un aumento de la actividad a un rango de IP desconocido o una región en la que no realiza negocios.hits sospechosos de IPs individuales – un gran número de hits de una sola IP. Los humanos normalmente solicitan unas pocas páginas y no Otras, mientras que los bots a menudo solicitan todas las páginas.,

- Fuentes de idioma-ver visitas de otros idiomas que sus clientes no suelen utilizar.

todo lo anterior son solo Indicadores aproximados de la actividad del bot. Tenga en cuenta que los bots maliciosos sofisticados pueden generar una firma realista, similar a la del usuario en su análisis web. Es recomendable utilizar una solución de gestión de bots dedicada que proporcione visibilidad completa del tráfico de bots.

Cómo detener el tráfico de bots: medidas básicas de mitigación

hay algunas medidas simples que puede tomar para bloquear al menos algunos bots y reducir su exposición a bots malos:

- Colocar robots.,txt en la raíz de su sitio web para definir qué bots tienen permitido acceder a su sitio web. Tenga en cuenta que esto solo es efectivo para administrar los patrones de rastreo de bots legítimos y no protegerá contra la actividad de bots maliciosos.

- Añadir formularios de registro, comentario o descarga. Muchos editores y sitios web premium colocan para evitar bots de descarga o spam.

- Establecer una alerta de JavaScript para notificarle del tráfico de bots. Tener JavaScript contextual en su lugar puede actuar como un zumbador y alertarlo cada vez que ve un bot o elemento similar entrando en un sitio web.,

¿cómo evaden la detección los Bots?

La tecnología Bot ha evolucionado durante la última década. Originalmente, los bots eran un script que golpeaba un sitio web para recuperar datos o realizar acciones. Estos scripts no aceptaban cookies y no analizaban JavaScript, lo que los hacía muy fáciles de detectar.

con el tiempo los bots se volvieron más sofisticados, aceptando cookies y analizando JavaScript, pero aún podían detectarse con bastante facilidad porque usaban elementos dinámicos del sitio web menos que usuarios humanos.,

la siguiente evolución fue el uso de navegadores sin cabeza como PhantomJS, que pueden procesar el contenido del sitio web en su totalidad. Aunque estos navegadores son más sofisticados que los bots básicos, los navegadores sin cabeza todavía no pueden realizar todas las acciones que los usuarios reales pueden.

los tipos más avanzados de bots se basan en el navegador Chrome y son casi indistinguibles de los usuarios reales. Estos bots incluso simulan la actividad humana, como hacer clic en los elementos de la página.

técnicas avanzadas de mitigación de bots

a medida que los bots evolucionaron, también lo hicieron las técnicas de mitigación., Actualmente hay tres enfoques técnicos para detectar y mitigar los bots defectuosos:

- enfoque estático: las herramientas de análisis estático pueden identificar solicitudes web e información de encabezado correlacionada con bots defectuosos, determinando pasivamente la identidad del bot y bloqueándolo si es necesario.

- enfoque basado en desafíos: puede equipar su sitio web con la capacidad de verificar proactivamente si el tráfico se origina En usuarios humanos o bots. Los detectores de bots basados en desafíos pueden verificar la capacidad de cada visitante para usar cookies, ejecutar JavaScript e interactuar con elementos., Una capacidad reducida para procesar este tipo de elementos es un signo de tráfico de bots.

- enfoque conductual: un mecanismo de mitigación de bot conductual observa la firma conductual de cada visitante para ver si es lo que dice ser. Behavioral Bot mitigation establece una línea de base de comportamiento normal para los agentes de usuario como Google Chrome, y ve si el usuario actual se desvía de ese comportamiento. También puede comparar las firmas de comportamiento con firmas anteriores conocidas de bots malos.,

al combinar los tres enfoques, puede superar los bots evasivos de todo tipo y separarlos con éxito del tráfico humano. Puede utilizar estos enfoques de forma independiente o puede confiar en los servicios de mitigación de bots para realizar técnicas por usted.

los servicios de mitigación de bots son herramientas automatizadas que utilizan los métodos anteriores para identificar bots. Estos servicios se pueden usar para monitorear el tráfico de API y detectar si se trata de tráfico de máquina legítimo o bots defectuosos que «ordeñan» su API.,

Los servicios avanzados de mitigación de bots utilizan la limitación de velocidad para cada cliente o máquina solicitante, en lugar de una IP completa, lo que le permite limitar el rastreo desde bots defectuosos. Una vez que se identifica un bot, estos servicios pueden propagar la información a través de la red, para garantizar que el mismo bot no pueda acceder a su sitio o API de nuevo.

vea cómo Imperva Bot Management puede ayudarle con las amenazas automatizadas.,

Imperva Bot Management

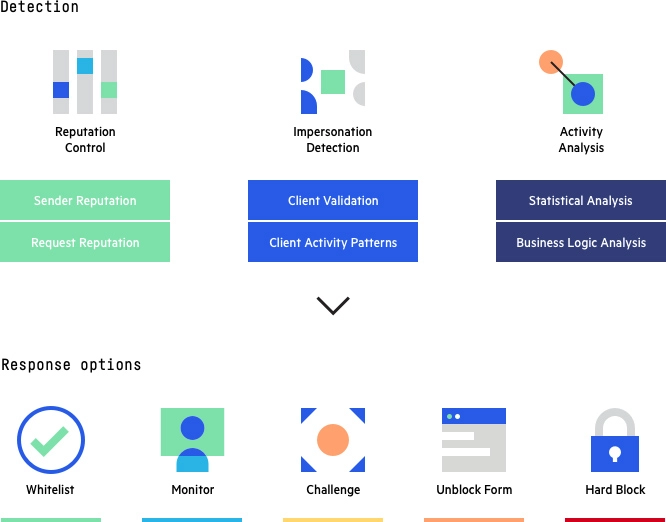

La solución de gestión de bots de Imperva utiliza los tres enfoques mencionados anteriormente (estático, basado en desafíos y basado en el comportamiento) para investigar a cada visitante de su sitio, ya sea humano o no, y compararlo con un ID de comportamiento. Puede proteger eficazmente contra bots maliciosos al tiempo que garantiza que los bots legítimos y los usuarios humanos tengan acceso ininterrumpido a su sitio.,

Imperva Bot Management: Métodos de detección y opciones de respuesta

Además de ayudar a mitigar la actividad de bots defectuosos, Imperva proporciona protección de múltiples capas para asegurarse de que los sitios web y las aplicaciones estén disponibles, sean de fácil acceso y sean seguros. La solución de seguridad de aplicaciones de Imperva incluye:

- API security: protege las API de bots y atacantes humanos al garantizar que solo el tráfico deseado pueda acceder a su punto final de API, además de detectar y bloquear exploits de vulnerabilidades.,

- Protección DDoS: mantenga el tiempo de actividad en todas las situaciones. Evite que cualquier tipo de ataque DDoS, de cualquier tamaño, impida el acceso a su sitio web e infraestructura de red.

- CDN: mejore el rendimiento del sitio web y reduzca los costos de ancho de banda con una CDN diseñada para desarrolladores. Almacene en caché recursos estáticos en el perímetro mientras acelera las API y los sitios web dinámicos.

- Web Application Firewall-permitir el tráfico legítimo y evitar el mal tráfico. Proteja sus aplicaciones en el perímetro con un WAF en la nube de clase empresarial.,

- RASP-Mantenga sus aplicaciones seguras desde dentro contra ataques conocidos y de día cero. Protección rápida y precisa sin firma ni modo de aprendizaje.

- Protección contra la adquisición de Cuentas: utiliza un proceso de detección basado en la intención para identificar y defenderse contra los intentos de hacerse cargo de las cuentas de los usuarios con fines maliciosos.