Redaktørens note: vi har opdateret vores originale indlæg om forskellene mellem GPU ‘er og CPU’ er, skrevet af Kevin kre .ell, og offentliggjort i December 2009. CPU ‘ en (central processing unit) er blevet kaldt hjernen på en PC. GPU sin sjæl. I løbet af det sidste årti har GPU ‘er imidlertid brudt ud af PC’ ens bo .y-rammer.

GPU ‘ er har antændt en verdensomspændende AI-boom. De er blevet en vigtig del af moderne supercomputing., De er blevet vævet ind i spredte nye hyperscale datacentre. Stadig værdsat af spillere, de er blevet acceleratorer fremskynde alle mulige opgaver fra kryptering til netværk til AI.

og de fortsætter med at skabe fremskridt inden for spil og pro-grafik inde i arbejdsstationer, stationære pc ‘ er og en ny generation af bærbare computere.

Hvad er en GPU?

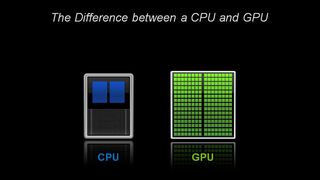

mens GPU ‘er (graphics processing unit) nu handler om meget mere end de pc’ er, hvor de først optrådte, forbliver de forankret i en meget ældre id.kaldet parallel computing. Og det er det, der gør GPU ‘ er så magtfulde.CPU ‘ er forbliver helt sikkert vigtige. Hurtig og alsidig, CPU ‘ er race gennem en række opgaver, der kræver masser af interaktivitet. Opkald til oplysninger fra en harddisk som svar på brugerens tastetryk, for eksempel.i modsætning hertil bryder GPU ‘ er komplekse problemer i tusinder eller millioner af separate opgaver og udarbejder dem på .n gang.,

det gør dem ideelle til grafik, hvor teksturer, belysning og gengivelse af figurer skal udføres på ATN gang for at holde billeder flyvende over skærmen.,v id=”bdcf9e66d4″>

Arkitektonisk, CPU ‘ en er sammensat af blot et par kerner med masser af cache-hukommelsen, der kan håndtere et par software-tråde på en gang., I modsætning hertil er en GPU sammensat af hundreder af kerner, der kan håndtere tusinder af tråde samtidigt.

GPU ‘ er leverer den engang esoteriske teknologi til parallel computing. Det er en teknologi med en berømt stamtavle, der indeholder navne som supercomputing genius Seymor Cray. Men snarere end at tage form af hulking supercomputere, GPU ‘ er sætte denne ID.til at arbejde i desktops og spillekonsoller på mere end en milliard spillere.

for GPU ‘ er var computergrafik først af mange Apps

Denne applikation — computergrafik — bare den første af flere morderapps., Og det har kørt den enorme r&D-motor bag GPU ‘ er fremad. Alt dette gør det muligt for GPU ‘ er at køre foran mere specialiserede chips med fast funktion, der betjener nichemarkeder.

en anden faktor, der gør al den magt tilgængelig: CUDA. Den parallelle computerplatform, der først blev frigivet i 2007, lader kodere drage fordel af computerkraften i GPU ‘ er til generel behandling ved at indsætte et par enkle kommandoer i deres kode.

Det lader GPU ‘ er spredes i overraskende nye felter., Og med støtte til et hurtigt voksende antal standarder-såsom Kubernetes og Dockers — applikationer kan testes på en billig desktop GPU og skaleres ud til hurtigere, mere sofistikerede server GPU ‘ er samt alle større cloud — tjenesteudbyder.

CPU ‘er og slutningen af Moores lov

med Moores lov, der blev afviklet, kom GPU’ er, opfundet af NVIDIA i 1999, lige i tide.

Moores lov indebærer, at antallet af transistorer, der kan proppes ind i et integreret kredsløb, fordobles hvert andet år. I årtier har det drevet en hurtig stigning i computerkraft., Denne lov, imidlertid, har kørt op mod hårde fysiske grænser.

GPU ‘ er tilbyder en måde at fortsætte med at accelerere applikationer — såsom grafik, supercomputing og AI — ved at dele opgaver blandt mange processorer. Sådanne acceleratorer, der er afgørende for fremtiden for halvledere, ifølge John Hennessey og David Patterson, vinderne af 2017 A. M. Turing Award, og forfattere af Computer Arkitektur: En Kvantitativ Tilgang skelsættende lærebog om mikroprocessorer.,

GPU ‘ er: nøglen til AI, Computer Vision, Supercomputing og mere

i løbet af det sidste årti er det bevist nøglen til et voksende udvalg af applikationer.

GPU ‘er udfører meget mere arbejde for hver energienhed end CPU’ er. Det gør dem nøglen til supercomputere, der ellers ville skubbe forbi grænserne for nutidens elektriske net.

i AI er GPU ‘ er blevet nøglen til en teknologi kaldet “dyb læring.”Deep learning hælder store mængder data gennem neurale netværk og træner dem til at udføre opgaver, der er for komplicerede til enhver menneskelig koder at beskrive.,

AI og Gaming: GPU-Drevet Dyb Læring Kommer Fuld Cirkel

Det dybe læring kapacitet er accelereret takket være integration af dedikerede Tensor Kerner i NVIDIA Gpu ‘ er. Tensor kerner accelerere store Matri operations operationer, i hjertet af AI, og udføre blandet præcision Matri.formere-og-akkumulere beregninger i en enkelt operation. Det fremskynder ikke kun traditionelle AI-opgaver af alle slags, det tappes nu for at fremskynde spil.,

i bilindustrien tilbyder GPU ‘ er mange fordele. De giver uovertruffen billedgenkendelsesfunktioner, som du ville forvente. Men de er også nøglen til at skabe selvkørende køretøjer, der er i stand til at lære af-og tilpasse sig — et stort antal forskellige virkelige scenarier.,

i robotik er GPU ‘ er nøglen til at gøre det muligt for maskiner at opfatte deres miljø, som du ville forvente. Deres AI-kapacitet er imidlertid blevet nøglen til maskiner, der kan lære komplekse opgaver, såsom at navigere autonomt.

inden for sundhedspleje og biovidenskab tilbyder GPU ‘ er mange fordele. De er selvfølgelig ideelle til billedopgaver. Men GPU-baseret dyb læring fremskynder analysen af disse billeder. De kan knuse medicinske data og hjælpe med at omdanne disse data gennem dyb læring til nye evner.

kort sagt er GPU ‘ er blevet vigtige. De begyndte med at accelerere spil og grafik., Nu accelererer de flere og flere områder, hvor computing hestekræfter vil gøre en forskel.

- AI Er at Spise Software

- AI-Drev Anledning af Accelereret Computing datacentre

- Hvad er Forskellen Mellem Hardware og Software Accelereret Ray Tracing?

- Hvad er Ma? -??

- Hvad er en virtuel GPU?

- Hvad er forskellen mellem strålesporing og rasterisering?,

- Hvad er forskellen mellem kunstig intelligens, maskinlæring og dyb læring?

- Hvad Er NVLink?

- Hvad er CUDA?